Son analogique vs numérique

Sommaire

C’est quoi ?

- Analogique = flux d’information continue. Il y a toutes les valeurs possibles entre 0 et 1.

- Numérique = flux d’information discrète. Entre 0 et 1, il n’y a rien.

En synthèse sonore :

- En analogique, l’information est donnée par un flux électrique continue donné en Volts (V).

- Exemples :

- Un oscillateur eurorack envoie des valeurs entre -5 et +5 V

- Un contrôleurs eurorack envoie des valeurs de 0 à 8 V ou -2,5 à +2,5 V

- Il s’agit donc de tensions générées par des variateurs de tension ou des potentiomètres.

- En numérique, l’information est donnée par un flux de valeurs discrètes de 0 et de 1, appelés des bits.

- Pour cela, il faut échantillonner un signal analogique pour en faire une suite de bits. L’information est décrite par des paquets de bits, appelés Bytes, qui hachent le son en tranches, générant ainsi une information discrète (digitale).

Échantillonnage

Afin de transformer un signal analogique en information numérique exploitable avec un ordinateur, nous avons besoin de deux valeurs :

- Un taux

- Une fréquence

Le Taux est une échelle de valeurs qui représente la pression acoustique, autrement dit, l’amplitude du son à un instant précis. Cette échelle est codée sur un nombre de bits choisi en fonction de la qualité voulue, généralement sur 16 ou 24 bits.

La fréquence est le nombre d’échantillons relevé en une seconde. Là aussi, on choisit une fréquence en fonction de la qualité voulue (44.1, 48, 96... kHz).

L’échantillonnage est effectué par un circuit électronique appelé ADC, ou Analogic Digital Converter. La qualité d’un tel circuit est un facteur important dans le choix d’une carte son. C’est souvent cette qualité qui en détermine le prix.

Inversement, le reconversion numérique/analogique est effectuée par un circuit électronique appelé DAC, ou Digital Analogic Converter.

L’un comme l’autre, ces composants électroniques doivent inclure une horloge très précise qui va prendre ou restituer fidèlement la succession d'échantillons.

Nyquist

« Harry Nyquist, né le 7 février 1889 à Nilsby (sv) (Suède) et mort le 4 avril 1976 à Harlingen (Texas, États-Unis), est un physicien ingénieur électronicien suédois qui a été un important contributeur à la théorie de l'information et à l'automatique. » (Wikipédia)

Une "règle de Nyquist" établit que, pour un son d’une fréquence f, il faut choisir une fréquence d’échantillonnage minimum de 2f pour une restitution correcte du son (voir ici).

L’oreille humaine n’étant capable d’entendre des sons que jusqu’à un maximum de 20 kHz, l’industrie (Philips) à fixé la fréquence d’échantillonnage des CD à 44.1 kHz (et plus tard, 48 kHz pour les DVD).

Dans les studios d’enregistrement, de masterisation et de post-production, des fréquences supérieures sont souvent utilisées : 96, 192, 384 kHz. Plus la fréquence d’échantillonnage est élevée, moins il y a de risque de perte d’information lors des multiples conversions ADC et DAC effectuées d’une machine à l’autre.

Au delà de 40 kHz, l’oreille n’est plus censée entendre quoi que ce soit mais, pour ceux qui ont une bonne oreille, il est possible d’entendre une différence de qualité entre un même le 44.1 kHz d’un CD ou en 48 kHz d’une DAT (ou DVD), le son de la DAT semblant plus clair et plus précis.

Compression

Afin de gagner de la place sur les supports et d’alléger la charge des canaux de transports de l’information, notamment, sur internet, il a été développé des algorithmes de compression pour réduire à la fois la taille des fichiers et les flux de données.

Il existe plusieurs types d’algorithmes, certains entraînant des pertes d’information et par conséquent de qualité, d’autres pas.

- Formats compressés avec perte les plus utilisées : mp3, wma, ogg

- Formats compressés sans perte les plus utilisées : flac

- Format non compressés : wav (PC), aiff (Mac)

Il est fortement déconseillé d’utiliser des formats compressés avec ou sans perte en studio et pour toutes utilisations professionnelles.

Traitement du son

Le traitement du son analogique se fait à l’aide de circuits électroniques analogiques comportant de nombreux composants tels que : Lampes, diodes, transistors, résistances, etc.

Le traitement du son numérique se fait à l’aide d’algorithme intégrées dans des logiciels, des puces ou des processeurs. Il existe des processeurs très puissants dédiés au traitement numérique : les DSP (Digital Signal Processor).

Le MIDI

MIDI n’est pas du son. C’est un langage de communication qui permet d’échanger des données entre les différents appareils traitant le son numérique comme analogique.

Je le cite ici juste parce que c’est aussi un flux de données numériques utilisés en musique.

Comparaisons

Flux audio ou de contrôle

En analogique, tout étant fait de flux électriques, on peut brancher n’importe quelle sortie dans n’importe quelle entrée si l’entrée accepte le niveau de tension et l’intensité de courant que la sortie délivre. Ainsi, en synthèse modulaire, on peut brancher la sortie d’un contrôleur dans une entrée audio ou une sortie audio peut être utilisée dans une entrée de contrôle ou de modulation.

Ce n’est pas le cas en numérique. Les débits de données audio sont énormes comparés aux débits de données de contrôle (MIDI, par ex.). Et surtout, l’information contenue dans ces données n’est pas la même. En synthèse numérique, on ne peut donc pas utiliser une sortie de contrôleur dans une entrée audio et inversement.

Aliasing

Un des phénomènes des plus gênants du numérique est celui de l’aliasing.

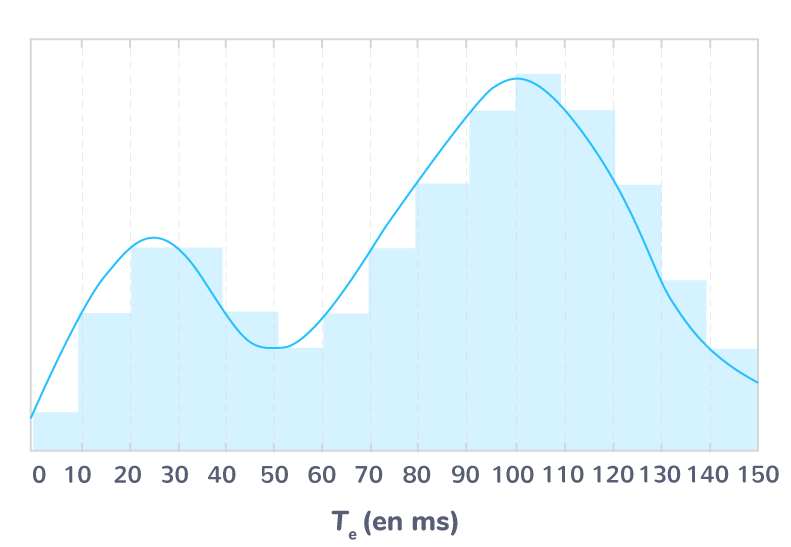

En échantillonnage, l’aliasing est un repliement des ondes sonores qui se produit dans les aigus quand une fréquence audio est supérieure à la fréquence d’échantillonnage. Cela génère des fréquences audio indésirable, généralement dans le grave, qui peuvent être fortement dissonantes.

L’aliasing désigne aussi le phénomène d’« escalier » entraîné par la numérisation. Aux fréquences utilisées en audio, ce n’est pas audible. Ça ne l’est pas non plus quand on utilise un contrôleur MIDI (7 bits, 128 pas) sur le volume du son. Par contre, ça devient très gênant quand il s’agit d’utiliser un tel contrôleur sur la variation de hauteur, surtout dans le grave. On entend nettement que le son ne glisse pas de façon continue mais par palier – d’où cette image d’escalier, "aliasing" se traduit par "crénelage" en français. Pour bien comprendre, grossissez une photo un grand nombre de fois et vous verrez ce type d’aliasing apparaître sous forme de pixels carrés. Si l’on "grossit" une onde sonore numérique, on obtient le même résultat.

Logiciels libres (les plus connus)

Traitement du son

- Audacity

- Wavosaure

DAW

- Ardour

- LMMS

- RoseGarden

Instruments virtuels

- Synth1 : Modélisation d'un synthétiseur analogique classique

- Aeolus : Grand orgue

- Hydrogen : Boîte à rythme avec vrai sons de batterie

- ZynAddSubFX : Synthétiseur de type analogique très complet

Programmation

- Pure Data

- Csound

- Processing